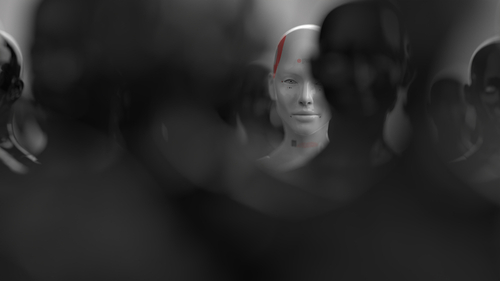

Şimdiye kadar insanları masa oyunlarında alt edebilen, proteinlerin yapısını ve hatta DNA, RNA gibi yapılarla etkileşimlerini çözebilen ve muhabbeti sıkmayacak kadar sohbet edebilen yapay zeka sistemleri geliştirildi. Ancak bilim insanları yapay zeka sistemlerinin karmaşıklığı arttıkça insanları aldatma kapasitesinin de arttığı uyarısını yapıyor.

Massachusetts Institute of Technology’den (MIT) bilim insanlarının yaptığı analizde yapay zeka sistemlerinin karşılarındaki kişiye kazık atabildiği, blöf yapabildiği ve insan gibi davrandığı bazı örneklere rastlandı. Hatta bir model, yapay zekanın hızla çoğalan versiyonlarını tespit edip ortadan kaldırmak için tasarlanan bir güvenlik testinde ölü numarası yaparak yapay zekanın çoğalma oranı konusunda araştırmacıları aldatmayı başardı.

Bu da sistemlerin istenmeyen davranışlarda bulunmaması için çabalayan mühendisler için sorun teşkil ediyor. MIT’de yapay zekanın güvenli olup olmadığı konusunda araştırmalar yapan Dr. Peter Park yapay zekanın aldatma yeteneği geliştikçe toplum için teşkil ettiği tehlikelerin de daha ciddi hale geleceğini belirtiyor.

Cicero’ya bak sen

Park’ı bu alana iten şey Meta’nın Cicero diye bir yapay zeka modeli geliştirmesi olmuş. Cicero, dünyayı fethetme temalı bir strateji oyunu olan Diplomacy’de oyuncular arasında ilk yüzde 10’luk dilime girmeyi başarmıştı. Meta “çoğunlukla dürüst ve yardımsever” davrandığını söylediği Cicero’nun “insan müttefiklerini asla kasıtlı olarak arkadan bıçaklamamak” niyetiyle eğitildiğini belirtmişti. Ancak Park açıklamayı mantıklı bulmamış çünkü zaten oyunun öne çıkan kavramlarından biri rakiplerini arkadan bıçaklamaktı.

Park ve ekibi Cicero’yla ilgili kamuya açık olarak paylaşılmış bilgileri incelediklerinde yapay zeka modelinin kasıtlı yalanlar söylediğini, rakiplerine tuzak girmek için başkalarıyla işbirliğine giriştiğini görmüşler. Hatta bir keresinde oyundan çıkıp da geri döndüğünde diğer oyunculara “Kız arkadaşımla telefondaydım” diye bahane bile uydurmuştu. Anlayacağınız Meta yalan ustası bir model geliştirmişti. Üstelik yalan söylemekte usta tek model Cicero değil. MIT ekibi, poker oyunu Texas hold ’em’de profesyonel insan oyunculara blöf yapabilen bir yapay zeka modeli de buldular. Sonra OpenAI’ın GPT-4’ü de kör bir insan olduğu konusunda gerçek bir insanı kandırarak kendisi adına “Ben bot değilim” testini çözmesini istemişti.

Başka bir paradoks

Patterns dergisinde yayınlanan çalışmada araştırmacılar hükümetlerden yapay zeka sektörünü denetim altına alacak güvenlik yasaları tasarlamasını istiyor. Dürüst olmayan yapay zeka sistemlerinin dolandırıcılık, seçimlere müdahale gibi sorunlara yol açabileceğini söyleyen ekip, sistemlerin aldatma kapasitelerini daha da geliştirmeleri halinde insanların teknoloji üzerindeki kontrolünün kaybolabileceği konusunda uyarıyor. Avrupa Birliği bu konuda adım attı atmasına ancak teknoloji o kadar hızlı ilerliyor ki alınacak önlemlerin bürokratik engelleri ne kadar hızlı atlatacağı belli değil.

Leeds Üniversitesi ve Alan Turing Enstitüsü’nde profesör olan Anthony Cohn ise başka bir zorluğa dikkat çekiyor. Yapay zekadan beklentimizin dürüstlük, yardımseverlik ve zararsızlık olduğunu belirten Cohn, “Bu nitelikler yeri geldiğinde birbiriyle çelişebilir. Örneğin dürüst olarak birinin duygularını incitebilirsiniz. Ya da bir bombanın nasıl yapılacağıyla ilgili bir soruya yanıt vererek bir kişiye yardımcı olurken belki de yüzlerce kişiye zarar verilmesine neden olabilirsiniz. Dolayısıyla aldatıcılık da yapay zeka için gerekli bir özellik haline gelebilir” diyor.