Yeni teknolojilere artan talep bakır fiyatını zirveye çıkardı

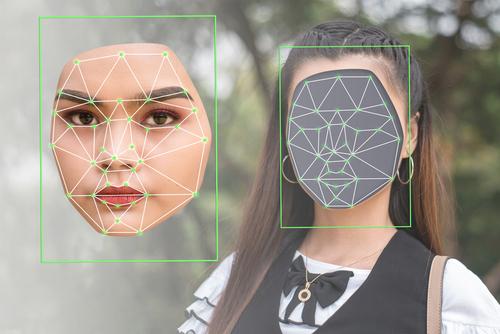

Deepfake teknolojisi yapay zeka şirketlerinin başını ağrıtacak boyutlara ulaşırken OpenAI yeni bir adım attı: Kendi geliştirdiği DALL-E 3 aracının ürettiği görselleri yüzde 98.8 oranında doğru tespit edebilen dedektör geliştirdi.

Fotoğraf: Shutterstock

Fotoğraf: Shutterstock Daha dün Met Gala’ya katılmayan ünlülerin sanki katılmışlar gibi yapay zekayle üretilmiş fotoğraflarının sosyal medyada nasıl en çok konuşulan konulardan biri olduğuna dair bir haber girmiştik. Katy Perry’nin annesi bile kızının törene katıldığına inanmışken biz nasıl yalanla gerçeği ayırt edebileceğiz ki? Intel bu alanda çalışmalar yapıyor ama şimdi yapay zekanın piri OpenAI, resim üreten yapay zeka modeli DALL-E’nin ürettiği içerikleri tespit edecek bir deepfake dedektörü geliştirdi.

Popüler sohbet robotu ChatGPT’nin geliştiricisi OpenAI yeni deepfake dedektörünü bir grup bilgi teyit araştırmacısıyla paylaşacağını söyledi. Şirket böylelikle geliştirdiği aracı gerçek dünya koşullarında test edebileceklerini ve hangi yolda ilerlemeleri gerektiklerini bulmayı amaçlıyor.

“Deepfake deepfake diyorsun, ama nedir bu deepfake” diye soranlarınız olabilir. Bir kişinin söylemediği ya da yapmadığı şeyleri sanki yapmış gibi göstermek için yapay zekadan faydalanılmasına deepfake deniyor. Yapay zeka araçları başka bir insanın hareketlerini ya da konuşmasını istediğimiz kişinin yüzüne ve sesine uygun bir şekilde ayarlayabiliyor. Belki birkaç ay öncesine kadar bu teknolojinin eksiklikleri kolayca fark edilebiliyordu ama birçok yazılımcı bu alanın üzerine düştüğünden çok hızlı bir ilerlemeden söz etmek mümkün. Artık bir fotoğrafın gerçekten var olup olmadığını anlamak için dedektörlere ihtiyacımız var.

OpenAI yeni dedektörünün DALL-E 3’le oluşturulan görsellerin yüzde 98.8’ini doğru bir şekilde tanımlayabildiğini söylüyor. Ne var ki bu dedektör Midjourney ya da Stability gibi popüler yapay zeka araçlarının ürettiği görüntüleri tespit etmek için tasarlanmadı. Ortada hâlâ yüzde birlik bir yanılma payı var ve bu pay bir ünlünün ya da siyasetçinin başına patlarsa ortaya istenmedik sonuçlar çıkabilir.

Fotoğraf: OpenAI

OpenAI, Google ve Meta gibi şirketler şimdi dijital içerikler için referans bilgileri oluşturma girişii olan Coalition for Content Provenance and Authenticity’nin (C2PA) yürütme komitesinde yer alıyor. C2PA standardı resim, video ve ses klibi gibi dosyaların ne zaman ve nasıl üretildiklerini ya da üzerlerinde ne gibi oynamalar olduğunu gösteren bir çeşit “etiket.”

OpenAI bunun dışında yapay zeka tarafından üretilen seslerin kolayca tanımlanabilmesi için “filigranlama” yöntemleri de geliştiriyor. Şirket bu yolla filigranların kaldırılmasını zorlaştırmayı umuyor.

Yapay zeka alanında çalışmalar yürüten şirketler geliştirdikleri araçlarla üretilen içeriğin hesabını verme konusunda giderek artan bir baskıyla karşı karşıya. Uzmanlar şirketlerden kullanıcıların yanıltıcı ve kötü niyetli materyaller üretmesini önlemelerini ve bu tür içeriklerin kaynağını ve dağıtımını takip etmek için yollar bulmalarını istiyor.

Bu yıl dünya en büyük seçim yılından geçiyor. Yapay zeka içeriklerinin takip edilmesi için yapılan çağrılar giderek artıyor. Son aylarda yapay zeka araçlarıyla üretilen ses ve görüntüler Pakistan, Slovakya, Tayvan ve Hindistan gibi yerlerde kampanyaları ve oylamaları etkiledi. Örneğin Pakistan’da İmran Han hapiste olmasına rağmen seçmenlerine seslendiği videolar yayınlayabildi.

OpenAI’nin yeni deepfake dedektörü sorunu çözmeye yardımcı olabilir mi? Olabilir. Ama sorunu kökünden çözmek için yeterli değil.