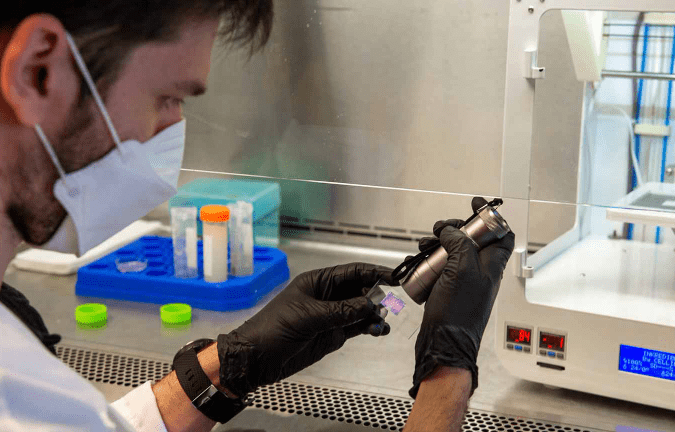

10’ca bilim arasından: Amerika’da bir Türk doktor, açık yaraları kapatacak 3D printerdan çıkan deri yaması icat etti

Microsoft, Meta ve Google, daha az parametreye sahip, oluşturulması ve eğitilmesi daha ucuz olan yeni sürümler yayınladı. Şirketler bu küçük dil modellerinden de büyük kârlar elde ediyor.

Yapay zeka yazılımının performansı genel olarak parametre sayısı arttıkça yükseliyor, daha karmaşık ve incelikli görevleri yerine getirebiliyor.

Yapay zeka yazılımının performansı genel olarak parametre sayısı arttıkça yükseliyor, daha karmaşık ve incelikli görevleri yerine getirebiliyor. Yapay zeka ürünlerini güçlendirmek amacıyla büyük dil modelleri oluşturmak için milyarlarca dolar harcayan yapay zeka şirketleri artık gelirlerini artırmak için küçük dil modellerine de yöneldi. Apple, Microsoft, Meta ve Google kısa süre önce daha az parametre içeren ancak yine de güçlü yeteneklere sahip yeni yapay zeka modelleri piyasaya sürdü.

Yapay zeka yazılımının performansı genel olarak parametre sayısı arttıkça yükseliyor, daha karmaşık ve incelikli görevleri yerine getirebiliyor. OpenAI’nin en son modeli GPT-4o ve Google’ın geçen hafta duyurduğu Gemini 1.5 Pro’nun 1,5 milyardan fazla parametresi olduğu tahmin ediliyor ve Meta açık kaynaklı Llama modelinin 400 milyar parametreli versiyonunu eğitiyor.

Ancak şirketler kurumsal müşterilerin üretken yapay zeka ürünlerini çalıştırmak için gereken büyük meblağları ödeme konusunda isteksizliğinin artmaya başladığını gördü. Ödemeye ikna etmede zorlanmaya başladı. Bu gelişme Meta ve Google gibi teknoloji gruplarını sadece birkaç milyar parametreye sahip küçük dil modelleri üretmeye mecbur etti. Şirketler küçük dil modellerini, hassas verileri de koruyabilen daha ucuz, enerji tasarruflu, özelleştirilebilir alternatifler olarak sunmaya başladı.

Google, Meta, Microsoft ve kısa süre içinde milyarlarca dolarlık değerlemeye ulaşan Fransız start-up Mistral, ilerleyen yetenekler gösteren ve belirli uygulamalara daha iyi odaklanabilen küçük dil modelleri de yayınladı.

Meta’nın küresel ilişkiler başkanı Nick Clegg Llama 3’ün yeni 8 milyar parametreli modelinin GPT-4 ile rekabet edebildiğini belirterek “Bence aklınıza gelebilecek hemen hemen her ölçümde üstün performans görüyorsunuz” dedi.

Microsoft ise yedi milyar parametreye sahip Phi-3-küçük modelinin OpenAI modelinin önceki bir versiyonu olan GPT-3.5’ten daha iyi performans gösterdiğini söyledi.

Daha küçük modeller aynı zamanda yapay zeka özelliklerinin cep telefonu gibi cihazlarda çalışmasını da sağlıyor. Microsoft Azur yöneticilerinden Eric Boyd daha küçük modellerin kısa bir süre sonra “Cep telefonlarına ve dizüstü bilgisayarlara kadar ilginç uygulamalarının devreye girebileceğini” söyledi.

Ayrıca Apple da en çok satan iPhone’unda çalışacak yapay zeka modelleri geliştirdiğinin ipucunu verdi. Şirket geçen ay metin tabanlı görevleri yerine getirmek üzere tasarladığı küçük bir model olan OpenELM’i piyasaya çıkardı.

OpenAI başkanı Sam Altman kasım ayında yaptığı açıklamada San Francisco merkezli start-up’ın müşterilerine “ayrı amaçlara hizmet eden” farklı boyutlarda yapay zeka modelleri sunduğunu ve bu seçenekleri oluşturmaya ve satmaya devam edeceğini ifade etti. Atman’a göre daha küçük modellerin gerçekten iyi çalışacağı bazı şeyler de bulunuyor.

Altman bununla birlikte OpenAI’nin akıl yürütme, görevleri planlama ve yürütme ve nihayetinde insan düzeyinde zekaya ulaşma yeteneği de dahil olmak üzere ölçeklendirilmiş yeteneklere sahip daha büyük yapay zeka modelleri oluşturmaya odaklanmaya devam edeceğini de söyledi.

Yapay zeka ürünlerini güçlendirmek amacıyla geliştirilen ve eğitilen dil modellerinin pahalı olmasının en önemi nedenlerinde birisi bu iş için kullanılan çiplerin fiyatının yüksekliği. Nvdia yapay zeka eğitim için geliştirdiği yeni nesil grafik işlemcisi Blackwell’i tanesi 30 ile 40 bin dolar arasında değişen fiyatlardan satıyor. Nvdia CEO’su Jensen Huang yeni geliştirdikleri Blackwell çipinin araştırma ve geliştirme harcamalarının 10 milyar dolara ulaştığını tahmin ediyor.

Büyük yapay zeka şirketlerinin bu yıl eğitim için Nvdia’nın çipinden yüzbinlercesini alacağı ve bunun da fiyatlara yansıyacağı belirtiliyor. Bu nedenle yapay zeka şirketlerinin artması beklenen fiyatları en azından sabit tutabilmek amacıyla bu yıl küçük dil modellerine daha fazla ağırlık vermesi bekleniyor.